Få dage før årets black friday, lancerede Google deres nye rapport om crawlstatistik i Google Search Console. Den nye og forbedrede udgave giver dig indsigt i hidtil usete mængder data omkring, hvordan Googlebot crawler din hjemmeside. I dette blogindlæg vil vi kigge lidt nærmere på de nye data fra Google, og hvordan du praktisk kan bruge disse data.

Crawlstatisk i et historisk perspektiv

Google Search Console var indtil maj 2015 kendt som Google Webmaster-værktøjer, men blev efter en rebranding omdøbt til det nuværende navn, Google Search Console. I januar 2018 blev det nuværende Google Search Console introduceret og i den forbindelse var der en række af de gamle værktøjer, der ikke blev opgraderet og tilføjet til den nye version. Rapporten om crawlstatistik var et af disse værktøjer.

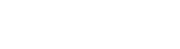

De sidste par år har vi kunnet tilgå rapport om crawlstistik under fanen ”forældede værktøjer” i det nuværende Google Search Console, hvor vi kun har haft mulighed for at se nogle overordnede rapporter om crawlstatistik gældende for seneste 90 dage:

Som billedet herover viser, er disse data meget overordnede. Oplevede man f.eks. et unaturligt fald i antallet af crawlede sider, var man nødt til at bruge andre værktøjer til at undersøge, hvilke sider, der var skyld i faldet på grafen. I sidste ende kunne det være nødvendigt at få fat i serverloggen, som efterfølgende krævede en del analysearbejde for at finde frem til årsagen. Sidder du i et lukket system, er det meget svært at få adgang til serverloggen og bruge dette til fejlsøgning.

Med lanceringen af den nye rapport om crawlstatistik i Google Search Console, er dette ændret markant.

Ny rapport om crawlstatistik i Google Search Console

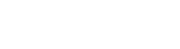

Inden du kigger nærmere på den nye rapport om crawlstatistik, skal du først finde frem til funktionen i Google Search Console.

Den ligger, modsat mange af de andre værktøjer i Search Console, ikke som sin egen fane i menuen. Google har i stedet valgt at placere den under “Ejendomsindstillinger”, hvor du kan finde den her:

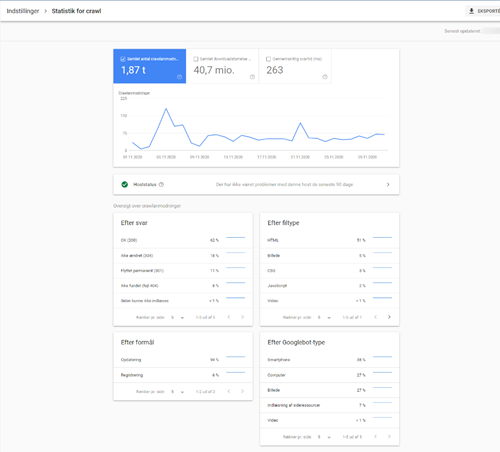

Når du klikker ”Åbn rapport”, kan du med det samme se, at vi har fået adgang til en masse ny data, som vi ikke tidligere har set:

Øverst har vi en rapport, der viser os generelle data omkring samlet antal crawlanmodninger, samlet størrelse på download, og gennemsnitlig svartid i løbet af de seneste 90 dage. Disse tre datasæt minder i høj grad om de datasæt, vi havde adgang til i det gamle værktøj.

Host status

Næste rapport er “Host status”, som rapporterer om der har været problemer med tilgængeligheden af din hjemmeside i løbet af de seneste 90 dage. Klikker du på “Host status”, får du vist tre faner, som giver dig yderligere data omkring tilgængeligheden for robots.txt filen, DNS-oversættelse og serverforbindelsen.

Hvis der ikke har været registreret problemer, vises et grønt flueben. Hvis der derimod har været problemer, vil der enten vises et rødt ikon eller et delvist grønt flueben.

Får du vist et rødt ikon eller et delvist grønt flueben, bør du klikke på “Host status” og kigge nærmere på, hvor Googlebot har oplevet problemer. Alt efter, hvilket CMS du benytter, kan fejl under “Host status” betyde, at du skal have fat i din udvikler eller udbyder af hosting for at få hjælp til at få rettet fejlen. Fejl der er registreret under denne del af crawlrapporten, kan betyde, at Googlebot har problemer med tilgængeligheden af din hjemmeside, og at den måske ikke crawler din hjemmeside, som den burde. Det er derfor vigtigt, at du reagerer på eventuelle fejl og snakker med din udvikler, så der kan fejlrettes.

Oversigt over crawlanmodninger

Den næste del af rapporten viser en oversigt over crawlanmodninger inddelt i forskellige områder. Det er data, vi ikke tidligere har set delt fra Google i dette omfang, og det giver os et indblik i, hvordan Googlebot crawler hjemmesiden og hjemmesidens ressourcer. Disse data er baseret på de seneste 30 dage.

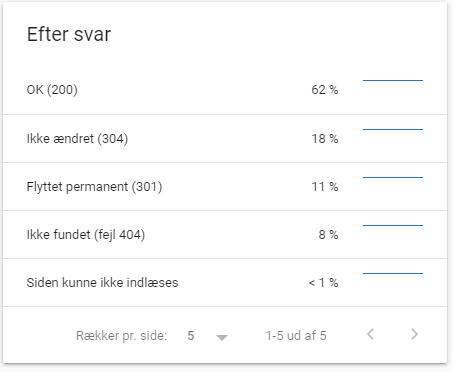

De to øverste viser crawlanmodninger efter svar og efter filtype.

I rapporten ”crawlanmodninger efter svar” bør størstedelen af resultaterne være status 200 (Ok) eller lignende positive svartyper.

I nedenstående eksempel kan vi se, at der er registreret en række 404-sider (8 %), mens resten af de crawlede sider og ressourcer er positive:

Vi kan nu klikke på “Ikke fundet (fejl 404)” og se, hvilke sider og ressourcer, Googlebot har registreret problemer med i løbet af de sidste 30 dage. Herved kan vi hurtigt finde frem til fejlene og omdirigere adresserne eller håndtere dem på anden vis, hvis det ikke er meningen at siderne skulle give statuskode 404.

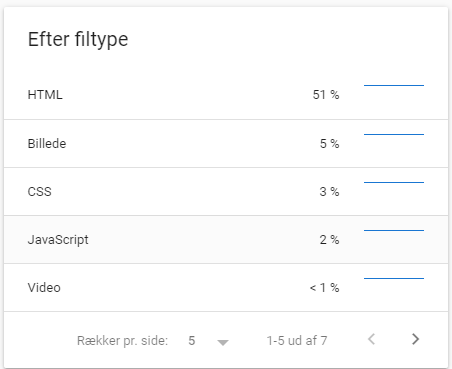

Rapporten om crawlede filtyper viser os fordelingen af de filtyper, Googlebot crawler på din hjemmeside:

Har du problemer med hastigheden eller den generelle tilgængelighed på din hjemmeside, kan denne rapport bruges til at undersøge, om der problemer med at hente ressourcer, der bruges på hjemmeside. Måske ligger der ressourcer fra en tredjepart, som er skyld i langsom indlæsning af indholdet på din hjemmeside? Du kan klikke ind på den enkelte filtype og tjekke, om svartider og crawlstatus er, som de skal være for at give dine brugere og Googlebot den bedste oplevelse.

Denne rapport kan også bruges til at danne et overblik over, om du har fået indekseret uønskede ressourcer, som burde være blokeret for crawling.

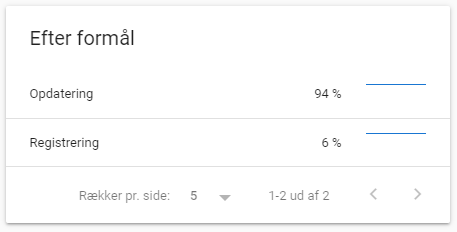

Næste rapport er crawlanmodninger efter formål. Denne rapport er meget interessant, da den viser, hvordan Googlebot crawler nyt og tidligere indhold på din hjemmeside:

I eksemplet herover, kan vi se, at hovedparten af crawlanmodningerne de sidste 30 dage har været opdatering af sider, der allerede er crawlet af Googlebot.

På webshops og hjemmesider, hvor der dagligt opdateres med nye produkter og indhold, bør fordelingen se anderledes ud end eksemplet herover.

Du kan klikke ind på begge typer og se, hvilke sider der ligger i hver rapport. Oplever du, at du har nye sider, der ikke er crawlet inden for de seneste 30 dage, kan det være en indikation på, at Googlebot har problemer med at finde frem til alt indhold på din side. Dette bør du undersøge nærmere – både ved at bruge søgefeltet øverst i Google Search Console på den enkelte adresse, men også ved at gennemgå de øvrige rapporter i Google Search Console for at sikre, at der ikke er problemer på din hjemmeside.

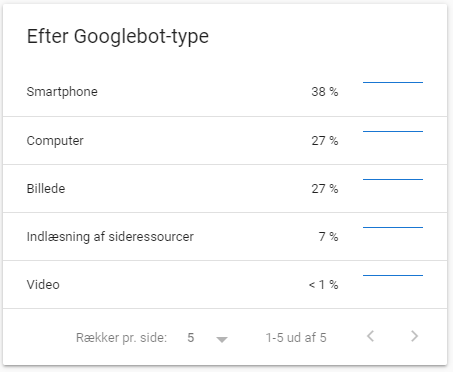

Den sidste rapport, crawlanmodninger efter Googlebot-type, viser os fordelingen af, hvilke brugeragenter fra Google, der crawler hjemmesiden:

I ovenstående eksempel kan vi se, at 38 % af crawlanmodningerne de seneste 30 dage, har været fra Googlebot til smartphone, mens 27 % har været fra Googlebot til computer. Selvom hjemmesiden fra ovenstående eksempel har været på Mobile First indeksering siden efteråret 2018, er det interessant at se, at Googlebot til computer fortsat crawler hjemmesiden i det omfang, som er gældende her. Selvom det kan virke som en fejl, er der umiddelbart ikke noget at være bekymret for i dette tilfælde. Når Googlebot bruger en anden crawlertype end den primære, skyldes det som regel, at den forsøger at finde flere informationer om besøgende fra andre enheder end den primære.

Du kan også bruge denne del af rapporten til at sikre, at du ikke har blokeret varianter af Googlebot ved en fejl. Indeholder ovenstående rapport f.eks. ikke informationer om ”Billede”, bør du tjekke om du har blokeret for ”Googlebot Image” i din robots.txt eller på webserveren ved en fejl.

Anvendelse af de nye rapporter

De nye rapporter om crawlstatistik i Google Search Console kan bruges til flere forskellige områder.

Først og fremmest er det nu blevet nemmere at følge med i, hvordan Googlebot crawler indhold på din hjemmeside og dermed holde øje med, om alt er, som det skal være. Du bør med jævne mellemrum kigge i de nye rapporter og sikre, at alt ser korrekt ud i forhold til crawling og dermed indeksering af indhold på din hjemmeside.

De nye rapporter om crawlstatistik er også meget anvendelige, hvis du foretager en større ændring på din hjemmeside. Foretager du f.eks. et siteskifte, migration af flere sider eller opdatering af dit system, er det nu nemmere end nogensinde før at følge med i, hvordan Googlebot behandler dine ændringer. Det samme gælder, hvis du omstrukturerer din kategori- eller produktstruktur, eller foretager andre større ændringer internt på hjemmesiden.

Du bør naturligvis også fortsat bruge de øvrige funktioner og rapporter i Google Search Console – de nye data om crawlstatistik gør det blot nemmere at holde øje med, hvordan Googlebot crawler hjemmesidens indhold og om der er problematikker, der skal kigges nærmere på. I forbindelse med et siteskifte, vil det være en god idé at bruge de nye rapporter sammen med f.eks. ”Dækning” i Google Search Console. På den måde, kan du i løbet af få dage efter skiftet holde øje med, om alt er, som det skal være, eller om der er problemer.

Som med al andet data i Google Search Console, er der nogle dages forsinkelse på data. Det betyder, at data i crawlstatistikken lige nu er ca. 3 dage forsinket. Derudover er data i Google Search Console ikke komplette, men uddrag af de samlede data Google har samlet om din hjemmeside. Disse uddrag er dog store nok til, at du kan bruge data som indikator for, om alt er som det skal være, eller om der er problemer, der skal håndteres.

Laver du et siteskifte eller en anden større ændring, vil der gå nogle dage, inden det er registeret i Google Search Console. Er du i tvivl om en side kan crawles og indekseres lige efter et skifte, bør du bruge funktionen ”Undersøg enhver webadresse i…”, som ligger som et søgefelt øverst i Search Console. Den giver et bedre øjebliksbillede af crawling og indeksering af den enkelte adresse og ressource.

Har du brug for hjælp eller spørgsmål til din Google Search Console, er du naturligvis velkommen til at kontakte os.